お盆をはさんで2週間ぶりの更新となるこのコーナー、お盆前の情報も含め、SEO担当者注目の情報をお届けしていく。

あなたのサイトは大丈夫? 手動ペナルティを受けていないか調べる「手動対策ビューア」をグーグルが公開

透明性がさらに向上した(Google ウェブマスター向け公式ブログ)

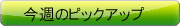

検索エンジンのガイドライン違反などによって手動による対策(俗にいう手動ペナルティ)が与えられているかどうかを確認できるツールを、グーグルがウェブマスターツールに実装した。

その名も「手動対策ビューア」だ。

そのサイトに手動の対策が実施されていなければ「手動によるウェブスパム対策見つかりませんでした」というメッセージ一文が表示されるだけだが、手動の対策が実施されていれば、何が原因なのかも併せて示してくれる。

ツールの機能や使用方法の詳細は、公式アナウンスを参照してほしい。

特に順位が大きく下がったときは、自分のサイトが手動の対策を受けているのではないかと心配になる。今までは警告文が送られてこなければ状態を知ることは難しかった。手動対策ビューアによって、ウェブマスターに対するグーグルの透明性は飛躍的に高まったと言っていいだろう。

日本語で読めるSEO/SEM情報

目標は1秒以内、グーグルがスマホサイトの高速化を提案

焦点を当てるのはAbove the foldのコンテンツ(Google ウェブマスター向け公式ブログ)

スマートフォン向けサイトの高速化に積極的に取り組むようにとグーグルは公式ブログで提案した。モバイルユーザーは速いサイトを求めているからだ。

「Above the fold」とは、「ユーザーが最初に目にする、スクロールしなくても表示されるエリア」のこと。

特に、「Above the fold」のコンテンツを1秒以内に表示するように推奨している。

具体的に次の施策を提示している。

- 200 ms 以内にレスポンスを返すようにする

- リダイレクトの数は極力少なくする

- 最初のレンダリング時のデータのやり取りを極力少なくする

- ユーザーに最初に見えるコンテンツを表示するのに必要となる JavaScript および CSS を外部参照せずにインライン化する

- ブラウザのレイアウト、レンダリング時間を考慮に入れる (200 ms)

- JavaScript の実行とレンダリング時間を最適化しておく

モバイルの高速化に役立つガイドラインも新たに公開した。現在は英語のみだが、いずれ日本語訳も出ると思われる。

ちなみに、LTEや3Gなどモバイル回線によってページの表示速度は変わるが、ここでいう「1秒」は、どんな回線であっても関係なく「ユーザーにとっての体感」の時間のことだと考えるのが適切だろう。

なかなかハードな条件だが、「ページ全体を1秒ですべて表示完了する」のではなく、「最初に見える部分を1秒以内に出す」なので、工夫によっては非現実的ではない。トライしてみるといいだろう。

スマホ向けサイトのUXを高める5つの施策

スマホユーザーが使いやすいサイトを構築せよ(Design Color)

サイトをスマートフォン対応させたときに意識したことを説明した記事。

以下の5つについて解説している。

- サイト幅はリキッドレイアウト&リンク領域は大きめに

- 動画やGoogleマップも画面サイズに応じて伸縮するように

- なるべく画面遷移をしないように

- PC版のデザインでも見られるように

- 最後までスクロールした後のことも考える

SEOではなくUX(ユーザーエクスペリエンス)に関するトピックだが、モバイル対応においてはモバイルユーザーのユーザー体験を向上させることがSEOに劣らず重要なので、ピックアップした。

ただし、1点だけ補足しておきたい。元記事で、iOSヒューマンインターフェイスガイドラインの記述を「アプリケーション内のタップ可能な要素には、約44×44ポイントのターゲット領域を割り当てる

」と参照している点だ。

この資料では「44ピクセル」ではなく「44ポイント」、つまり約1.55cmという画面上での表示サイズを示している点には注意しておきたい(ただしiOSの標準解像度のデバイスでは、1ポイント=1ピクセル相当なのでこれを「44ピクセル」と読み替えても問題ない)。

301でペナルティからの逃走を試みたサイトの結末

人工リンクは最後には見つかってアウト(SEMアドバイザーの揺さBrain!)

グーグルからペナルティを受けていたサイトが、301リダイレクトを利用していったんはペナルティを回避できたものの、再び捕まってしまったという経過を観察した記事。

ことの経過を簡潔にまとめると次のとおりだ。

以前は上位にいた競合サイトが、順位を大きく下げた。ほぼ間違いなく人工リンクが原因で、グーグルに手動の対策を受けたかスパム対策のアルゴリズムに捕まったと推測される。

そのサイトから301リダイレクトした別のサイトが再び上位に現れた。問題になったと思われる元サイトへの人工リンクはそのままの状態だ。

上位に出てきた6日後に、そのサイトは200位台に急降下した。

根本的な問題を解決することなく301リダイレクトを悪用したペナルティ逃れは、わずか5日で幕を閉じた形だ。

グーグルは良い仕事をしたと言っていいだろう。301リダイレクトはリンクの良い評価も悪い評価も区別せずに引き継ぐため、こうなるのは当然だといえば当然なのだが。

この発見を記事に書いた亀田氏が、Google+に投稿したコメントも紹介しておく(限定公開なのでリンクはしない。本人には引用の許可を得ている)。

最近思う事。

競合サイトがそろって自演リンクをつけてくれるおかげで助かっているという事。

どんどん自演リンクをつけてほしい。一時的に抜かれても長い目で見れば負けてないのは実証済み。

グーグルのガイドラインを守ったSEOを施策している亀田氏ならではの、自信に満ち溢れた言葉だ。

サブドメインのペナルティ解除が親ドメイン名にも及んだ

サブとルートは一心同体?(nobuki hamajima on Google+)

Google+で見かけた、手動対策に関する興味深い事例を紹介する。

とあるドメインのサブドメインサイトの手動対応が取り消されたのですが、ルートドメインのサイトも手動ペナってた筈なのがなくなってました。

これはどういう事なのか。。。・ルートとサブのサイトに関係性はなしで、両方ともに不自然リンクで手動ペナってました。

・サブのみ解除のメールきたのでルートの方も確認したらペナがない事に。

解説すると、独自ドメイン名(元記事では「ルートドメイン」と記述)のサイトと、そのサブドメインのサイトがあり、その両方が手動による対策を受けていた状況だったようだ。

- 独自ドメイン名のサイト: http://example.com/

- サブドメインのサイト: http://sub.example.com/

ところが、サブドメインのサイト(sub.example.com)のほうの手動対策が解除されたら、同時にその親ドメイン名である独自ドメイン名のサイト(example.com)の手動対策も解除されたのだ。

独自ドメイン名とそのサブドメインは、検索エンジンの扱いにおいて共通の存在のように見えるときもあれば、別々の存在のように見えるときもある。

たとえば、親ドメイン名のサイトのサイトリンクには、サブドメインのリンクも出てくることがある。一方、サブドメインに張られたバックリンクの効果は親ドメイン名の評価を押し上げたりはしないはずだ(サブドメインのサイトから親ドメインのサイトへリンクを張るという間接的な効果は別だが)。

手動による対策に関しては、独自ドメイン名とそのサブドメインの関係はどうなのだろうか? 完全に別扱いなのか、それとも身内扱いなのか。謎は深まる。

![海外SEO情報ブログ]() 海外SEO情報ブログの

海外SEO情報ブログの

掲載記事からピックアップ

米Google検索に導入された新しい機能とiOSに関するアクセス解析の記事を今週はピックアップ。

- Google、「In-depth articles」を導入。質が高い、深く掘り下げた記事を別枠で検索結果に表示。

schema.orgの実装を推奨している点に注目 - 【朗報】iOS 6のSafariがGoogle検索のリファラーを送信するようになる

アクセス解析者に助かる変更

- これであなたもウェブスパム博士、グーグルがスパムを解説する動画を公開

- 再審査リクエストを送りたくても送れなくなった

- ウェブマスターツールに出てこないリンクが問題視されるのはなぜ?

- 低品質ページは301か404か

- 「robots.txtの構成ミスでインデックス削除」の体験談

- 上級者向けSEOガイド2/9 : サイトスピードとパフォーマンス改善

- リンク構築で「コンテンツ・イズ・キング」は絶対か?

海外のSEO/SEM情報を日本語でピックアップ

これであなたもウェブスパム博士、グーグルがスパムを解説する動画を公開

日本語字幕付きなのが嬉しい(Google Webmasters on YouTube)

グーグルは、手動対策ビューアのリリースと同時に、手動対策の対象になるウェブスパムを説明する動画を公開した。おなじみのマット・カッツ氏と他のウェブマスタースパムチームのグーグル社員が登場している。

筆者が最も評価したいのは、すべて日本語訳の字幕が付いている点だ。機械翻訳ではなくきちんと人間の手が入っているので、不自然な日本語もない。

グーグルが何をウェブスパム行為とみなすのか、もしスパム行為を犯してしまい手動による対策を受けてしまったらどのように対処しなければならないのかを、これらの動画で学習しておこう(もちろん、日本語字幕をオンにして)。

- クローキング/不正なリダイレクト

- 隠しテキスト/キーワードの乱用

- 悪質なスパム

- 価値のない質の低いコンテンツ

- サイトからの不自然なリンク

- サイトへの不自然なリンク

- サイトへの不自然なリンク - リンクへ影響する対策を実施

- ユーザー生成スパム

再審査リクエストを送りたくても送れなくなった

手動の対策を受けているときだけ(Search Engine Roundtable)

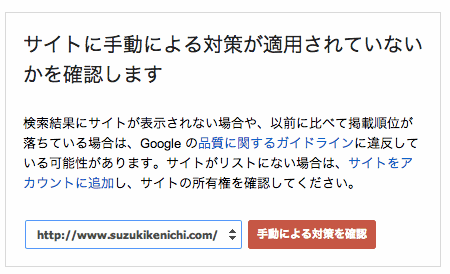

日本語記事でピックアップした手動対策ビューアの導入に伴い、再審査リクエストの送り方に変更が生じた。

手動による対策を受けている状態のときだけ、再審査リクエストを送信できるようになったのだ。

再審査リクエストページにアクセスすると、手動対策ビューアを確認するように促される。

手動の対策を受けていないときは、その旨が表示されるだけで何もできない。

一方、手動の対策を受けているときは、「再審査をリクエスト」の赤いボタンが表示され、再審査リクエストを送信できるようになる。

今までは、手動対策を受けていようがいまいが、いつでも再審査リクエストを自由に送れた。手動の対策を受けていないのに再審査リクエストを送り、「手動の対策は与えていません」という返信が返ってきた事例は数多くある

少し順位が下がっただけで再審査リクエストを送るサイト運営者もいたようで、グーグルも困惑していたかもしれない。今後は無用なリクエストが減るに違いない。

ウェブマスターツールに出てこないリンクが問題視されるのはなぜ?

グーグルが求めているのは実質的な努力(Search Engine Land)

不自然なリンクに対する警告を受け取ったら、問題となるリンクを見つけ出して削除しなければならない。その「問題となるリンク」を発見する手がかりになるのは、ウェブマスターツールで入手するリンクレポートだ。複数のグーグル社員がウェブマスターツールを頼るように指示している。

ところが、再審査リクエストの不合格通知を受け取ったときに、「まだ残っている」として例示されるリンクがウェブマスターツールに出ていないことがある。ウェブマスターツールではすべての被リンクを表示するわけではないからだ。

「ウェブマスターツールを見ろ」と言っているくせに、ウェブマスターツールでは見えないリンクが問題視されることに関して、米グーグルのウェブスパムチームのトップ、マット・カッツ氏は次のようにコメントした。

我々は、ウェブマスターツールで表示されるリンクのリストで(問題のあるリンクの)サンプルを提示しようとしているし、それらの(ウェブマスターツールで表示される)リンクに基づいて再審査リクエストを判断したいと思っている。

しかしながら、問題のあるリンクの典型的な例が(ウェブマスターツールでは表示されていないなかに)あるならば、そういったリンクを(ウェブマスターに)知らせることもある。

というのも、そうすることで、ウェブマスターがさらに多くの問題を見つけて修正でき、より正しい方向に向かうのに役立つと考えるからだ。

答えになっているような、なっていないような、しっくりこない回答だ。

マット・カッツ氏からこのコメントを得たバリー・シュワルツ氏は次のように締めくくっている。

通常、グーグルは悪いリンクをすべて削除することは求めていない。悪いリンクのほとんどを取り除いたという実質的な努力を見たいのだ。

ウェブマスターツールのレポートに出てくるリンクを手がかりにすることは確かなことだとしても、ツールに出てこない不自然なリンクがまだ残っているため、努力が足りないと判断されるのだろう。

元はといえば、自分の意思で張った不正なリンクだ。どこにどんなリンクを張ったかを知っておくべきだったのだ。自分も把握していないリンクを、手当たり次第に増やしてきた責任はその人自身にある。グーグルを責めるのは筋違いなのかもしれない。

低品質ページは301か404か

404は最後の手段(High Rankings Advisor)

サイト内にある質の低いページをどう扱うべきか、High RankingsのCEOであるジル・ウェイレン氏が、次のようにアドバイスしている。

アクセス解析ツールを見て、価値のあるトラフィックが検索エンジンからそのページにないことを調べ、本当に質が低いのかどうかを確認する。

多少なりとも検索からのトラフィックがあり、訪問ユーザーの役に立っている可能性が少しでもあるとしたら、そのページを何らかの形でサイトに組み込む方法を考える。いくばくかのアクセスであっても失うのはもったいない。

確実に質が低いと断定できたのならば、そのページは削除する。

削除したURLに対するアクセスは、404エラーにするよりは、元のコンテンツに最も関連するページに301リダイレクトするほうがいい。特にそのページにリンクが張られていたとしたら、なおさらだ。ウェブマスターツールにクロールエラーのレポートが発生することも防げる。

推奨してはいないが、最後の手段としては404を選択することにもなるだろう。もしくは残しておくなら、noindex robots metaタグを追加しておくかだ。

「robots.txtの構成ミスでインデックス削除」の体験談

問題解決後はインデックスに復活(WebmasterWorld)

robots.txtの構成ミスにより、サイトのコンテンツが検索エンジンから消えた事例と、その状態から回復するまでの体験談を、WebmasterWorldフォーラムのモデレータが語っている。

robots.txtが500エラーを返す状態になっていて、2週間以内にサイトが検索結果から消えてしまった。

robots.txtを修正したら、4日以内に元に戻った(最初に回復したのはトップページで、トップページにもっとも多くトラフィックが発生した)。

また、公開前のサイトで使っていた「Disallow: /」を記述したrobots.txtを(誤って)アップロードしてしまったこともあった。

5日後に検索順位が大きく下がった。問題に気付いたのはその日だった。正しいrobots.txtに差し替え、2週間半後に完全にトラフィックが回復した。

この状況に関して、次のように分析し、ファイルを元に戻す以外の対処法を説明している。

元に戻るまでに長い時間がかかった理由は、多くのトラフィックが内部のページに来るためだった。トップページのランキングは、正しいrobots.txtをアップロードして2日後に元に戻ったが、内部のページが元に戻るまでには2週間半かかった。

どちらのケースも、修正後直ちにウェブマスターツールのFetch as Googleで正常であることを検証した。それからルートページに対して再度Fetch as Googleを実行し、「URL とすべてのリンク ページ」を選択してURLをインデックスに送信した。

トップページやトップページからすぐにリンクされている少数のディレクトリやページに検索からのトラフィックがやって来るのであれば、回復スピードは速い。対して、かなりの割合の検索トラフィックが深いリンク階層の内部ページにやってくるのであれば、回復スピードは遅くなる。

あってはならないことだが、robots.txtで予期せぬ事態が発生したときの参考になるだろう。

![SEO Japan]() SEO Japanの

SEO Japanの

掲載記事からピックアップ

サイトの高速化とリンク構築の記事を今週はピックアップ。

- 上級者向けSEOガイド2/9 : サイトスピードとパフォーマンス改善

難易度は高いが非常に実践的 - リンク構築で「コンテンツ・イズ・キング」は絶対か?

重要なのはコンテンツではなく価値

- 内容カテゴリ:SEO

- コーナー:海外&国内SEO情報ウォッチ

※このコンテンツはWebサイト「Web担当者Forum - 企業ホームページとネットマーケティングの実践情報サイト - SEO/SEM アクセス解析 CMS ユーザビリティなど」で公開されている記事のフィードに含まれているものです。

オリジナル記事:あなたのサイトは大丈夫? 手動ペナルティを受けていないか調べる「手動対策ビューア」をグーグルが公開 など10+4記事 [海外&国内SEO情報ウォッチ] | Web担当者Forum

Copyright (C) IMPRESS BUSINESS MEDIA CORPORATION, an Impress Group company. All rights reserved.